Ciclo formativo en Big Data y ciencia del dato para la estadística oficial

Vivimos inmersos en un diluvio de datos, una explosión de información sin precedentes en la historia de la humanidad que ha dado lugar a un nuevo paradigma que se podría etiquetar como “datificación” de la cotidianeidad: el nivel de interconexión de la sociedad actual, donde las redes sociales ponen en contacto a las personas, donde las personas están siempre conectadas a diferentes dispositivos móviles y donde las máquinas y sistemas corporativos también se conectan entre sí para interoperar o intercambiar información, ha provocado la digitalización de todos los aspectos de la actividad humana. Esta revolución digital está dando lugar a montañas de datos, no estructurados en su mayoría, en forma de registros web, videos, grabaciones de voz, fotografías, correos electrónicos, posts, etc. a la espera de poder ser explotados.

En este contexto, el término Big Data hace referencia a la capacidad para recoger y analizar a gran velocidad enormes volúmenes de datos, muy variados en su forma o estructura, para establecer relaciones que aporten conocimiento a partir de una información demasiado compleja para ser captada a simple vista. Aunque los métodos que definen las técnicas Big Data, fundamentalmente vinculados a la estadística computacional, el aprendizaje automático y la minería de datos, tienen desde hace ya tiempo un largo recorrido, su aplicación en la actualidad requiere de competencias profesionales que han dado lugar al denominado perfil multidisciplinar de científico de datos.

A la vez existe una presión constante sobre los órganos estadísticos oficiales para generar con mayor celeridad información estadística más variada y detallada, mientras se exige concurrentemente reducir la carga de respuesta de los informantes y los costes económicos de la actividad estadística. Además, la irrupción de nuevas necesidades de información y la disminución de las tasas de respuesta en las operaciones de recogida directa de información estimula la búsqueda de fuentes alternativas de información estadística. Esto puede lograrse mediante el uso e integración de datos administrativos, un ámbito en el que la Estadística Oficial andaluza lleva ya tiempo trabajando, y también mediante el aprovechamiento de la oportunidad que ofrece el actual estado de “datificación” universal, es decir, mediante el acceso y uso de otros conjuntos masivos de datos –los llamados Big Data– que se generan como subproducto de procesos que no están directamente relacionados con fines de producción estadística. Ejemplos de este tipo de fuentes incluyen la actividad de comunicaciones registrada por las compañías de telefonía móvil, los mensajes de redes sociales como Twitter y Facebook o el comportamiento de búsquedas en Internet de Google Trends. Aunque estas nuevas fuentes de datos adolecen de inconvenientes, como por ejemplo que el proceso que genera los datos es desconocido y probablemente selectivo con respecto a la población objetivo, el auténtico reto inicial para la elaboración de estadísticas oficiales a partir de fuentes Big Data pasa por la formación y especialización técnica de los estadísticos en los métodos de análisis y en el uso de las tecnologías propias de este nuevo campo, en particular, y en la inclusión en su currículo de las competencias de Ciencia del Dato, en general.

La Estadística Oficial europea no es ajena a la oportunidad que puede suponer el aprovechamiento de este nuevo paradigma, tal y como lo demuestra la adopción del Plan de Acción sobre Big Data y su Hoja de Ruta 1.0 por parte del Comité del Sistema Estadístico Europeo. En dicho plan se establecen las líneas maestras a corto, medio y largo plazo para la integración de las fuentes Big Data en el modelo de producción de estadísticas oficiales del Sistema Estadístico Europeo. Entre las estrategias incluidas se contempla el impulso de programas formativos destinados a modernizar las competencias profesionales de los técnicos del SEE en materia de Big Data y Ciencia del Dato, lo cual ha dado lugar a la inclusión de cursos sobre esta materia en las últimas ediciones anuales del Programa Europeo de Formación Estadística (ESTP).

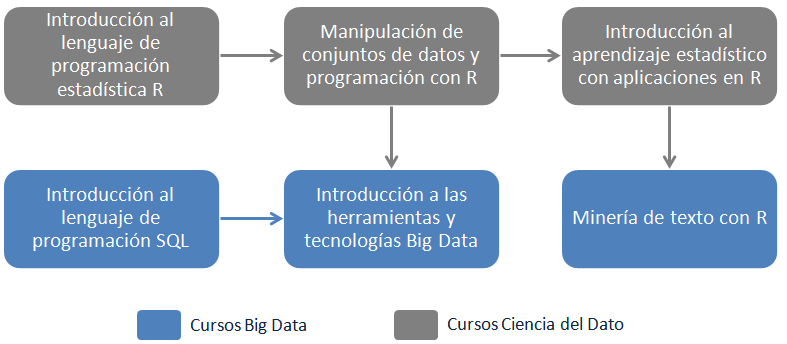

Desde el año 2016 el Programa de Formación del IECA se alinea con esta estrategia. Para este año 2017 se ha diseñado un ciclo formativo, compuesto por seis cursos interrelacionados, cuya orientación viene dada por un circuito en el que se proporcionará una inmersión introductoria en los métodos de modelado y análisis propios del campo de conocimiento del Aprendizaje estadístico, junto con las herramientas informáticas para su aplicación práctica, acompañado por una introducción al estado de las Tecnologías de la Información para el procesamiento de grandes conjuntos de datos:

- Introducción al lenguaje de programación estadística R

- Manipulación de conjuntos de datos y programación con R

- Introducción al aprendizaje estadístico con aplicaciones en R

- Minería de texto con R

- Gestión de bases de datos relacionales: introducción al lenguaje de programación SQL

- Introducción a las herramientas y tecnologías Big Data

El ciclo formativo tiene una duración de 117 horas y se desarrollará entre junio y noviembre de 2017 por profesorado perteneciente al Departamento de Estadística e Investigación Operativa de la Universidad de Sevilla. Su diseño, basado en una estructura de itinerario curricular, hace que sea especialmente recomendable para asegurar un aprovechamiento óptimo que los participantes cursen el conjunto íntegro de los seis módulos que lo componen o, al menos, que se respete el cumplimiento de los prerrequisitos señalados en la mayor parte de los cursos programados.